1) Princípios Quânticos

a) Uma nova mecânica

No fim do século XIX, a Física enfrentava uma gigantesca mudança. Até aquela época, a mecânica clássica de Newton e o eletromagnetismo de Maxwell forneciam um corpo teórico que explicava com gigantesca precisão desde muitos dos fenômenos mais cotidianos até os mais complexos, como as órbitas dos astros e a natureza eletromagnética da luz. Houve mesmo uma corrente de pensamento que acreditava que não havia muitos outros fenômenos físicos a serem descobertos. No entanto, ao se investigar problemas sobre a natureza mais fundamental da matéria, como as órbitas dos átomos e a emissão de radiação eletromagnética em corpos aquecidos, os físicos se depararam com fenômenos inexplicáveis sob a ótica da física clássica. Claramente, como foi aos poucos sendo percebido pela comunidade científica, o mundo microscópico é governado por leis bem diferentes daquelas com as quais estamos acostumados.

Com a descoberta dos raios catódicos em 1838 por Faraday, iniciou-se a idéia de que algumas quantidades na física eram quantificadas. Mais tarde, em 1897, John Joseph Thompson propõe e prova a existência de uma partícula de massa infimamente menor que a massa de um átomo de hidrogênio, e portadora de carga negativa. Estamos falando do clássico elétron. Vinte anos antes, em 1877, Boltzmann propõe a existência de estados de energia discretos para um sistema físico, idéia aproveitada por Planck em 1900 para formular a teoria de que toda a radiação eletromagnética é transmitida na forma de pacotes discretos de energia, aos quais deu o nome “quanta”. O trabalho de Planck culmina na descoberta de uma constante universal, batizada de constante de Planck, que determina a energia transmitida por cada quanta, em determinada freqüência do espectro eletromagnético. Niels Bohr, em 1920, cria um novo modelo atômico utilizando a teoria de Planck. Este modelo resolve o problema da instabilidade do átomo, pois de acordo com o modelo planetário de Rutherford, partículas negativamente carregadas orbitando ao redor de um núcleo positivo acabariam por colapsar em seu interior.

Em resumo, a chamada “antiga teoria quântica” foi uma série de resultados obtidos no início do século XX que explicavam satisfatoriamente fenômenos até então incompreendidos envolvendo a estrutura interna das moléculas, átomos e constituintes internos de átomos. A idéia principal da antiga teoria quântica era a quantificação dos fenômenos e quantidades quânticas. Em 1926, Erwin Schrödinger propõe uma teoria ondulatória da mecânica que explica com sucesso todos os resultados obtidos pela teoria quântica desenvolvida até então.

Um ano mais tarde, Werner Heisenberg descobre outro conceito fundamental e estranho da mecânica quântica, que afirma que é impossível ter certeza simultânea sobre duas propriedades de qualquer partícula subatômica. Por exemplo, quanto maior a certeza sobre a posição de um elétron, menor seria a certeza sobre sua velocidade. Intuitivamente, o conceito é simples de se entender. Basta pensar na forma como observamos partículas subatômicas. Para tentar determinar a posição de um elétron, por exemplo, podemos excitá-lo direta ou indiretamente, através da incidência de radiação. O problema é que, ao fazer isso, interagimos com o elétron e mudamos seu estado, de forma que, em qualquer tipo de medida, sempre acabamos alterando os estados quânticos das partículas de maneiras imprevisíveis. Schrödinger formalizou então o conceito de estado de uma partícula, através da chamada função de onda. A função de onda é matematicamente expressa como sendo uma função das posições, momentos ou spins, e retorna a probabilidade dessas grandezas assumirem determinados estados no sistema. Ou seja, ela descreve todos os estados possíveis que determinado sistema quântico pode assumir e as respectivas probabilidades de se obter medidas específicas de um estado ou outro. Claramente, é uma ferramenta estatística que lida muito bem com o princípio da incerteza descoberto por Heisenberg.

Para a física contemporânea, a incerteza é considerada uma característica intrínseca do mundo quântico. Em outras palavras, nossas tecnologias de medição não seriam apenas insuficientemente avançadas para realizar medições precisas, mas a própria natureza fundamental do mundo subatômico seria probabilística. Esta interpretação da função de onda impõe limites ao determinismo científico que dominou a física anterior ao século XX, justamente por propor que o mundo, em sua natureza mais fundamental, seria probabilístico. Isto se opõe fortemente à física clássica, pela qual, conhecidas todas as condições iniciais e leis que governam determinado fenômeno, toda a evolução temporal do mesmo estaria completamente determinada.

Adicionalmente, a interpretação da função de onda nos leva ao conceito da superposição de estados. Em um sistema quântico, todas as possíveis amplitudes da função de onda estariam sobrepostas umas às outras. Na prática, isso pode ser interpretado como o que poderia ser o conceito mais estranho da mecânica quântica: todos os possíveis estados de um sistema estão naturalmente sobrepostos, até se realize uma medida. Assim, uma partícula qualquer estaria em todos os estados possíveis simultaneamente, até que fosse observada. Pelo princípio da correspondência, só então a partícula colapsaria num estado aleatório, de acordo com as probabilidades da sua função de onda.

Assim como a função de onda, o postulado da correspondência também possui um significado duvidoso. Apesar de todos estes fenômenos violarem nosso senso comum sobre a realidade, se a mesma emerge do mundo quântico, todas as possibilidades existentes em um sistema com um número gigantesco de partículas acabam por se colapsar no que nós somos capazes de detectar. E a grande questão filosófica permanece: como e por que o ato de medir ou observar colapsa a partícula em um único estado? Estaria a natureza de alguma forma se adaptando à presença da consciência humana ou seria nossa mente apenas muito limitada para perceber infinitas visões da realidade?

b) A ação fantasmagórica à distância

Em 1935, Albert Einstein, Boris Podolsky e Nathan Rosen propuseram um experimento mental objetivando demonstrar que a mecânica quântica, embora tivesse alcançado absoluto sucesso até então na explicação e mesmo previsão de fenômenos, não era uma teoria completa. Este artigo, que deu origem ao chamado paradoxo EPR (Paradoxo de Einstein-Podolsky-Rosen), refuta o princípio da não-localidade. A não-localidade é a afirmação de que alguns fenômenos físicos poderiam ocorrer instantaneamente, ou seja, poderiam ser diretamente influenciados por ações “não-locais”, que acontecessem em qualquer lugar e a qualquer distância. O paradoxo EPR provou que certos aspectos da teoria quântica implicavam na existência da não-localidade, fato que entrava em conflito direto com a teoria da Relatividade de Einstein, pela qual nenhuma informação poderia viajar mais rápido que a luz.

Mais uma vez, a teoria quântica provou ser mais estranha do que qualquer expectativa, pois certas partículas, sob determinadas condições, podem se “entrelaçar” uma à outra, sendo impossível alterar o estado de uma sem que a outra seja imediatamente afetada. É claro que, em primeiro momento, acreditou-se que esta aparente coordenação indicasse que de alguma forma as partículas fossem capazes de trocar informações a velocidades superluminais (acima da velocidade da luz); este estranho fato foi apontado por Einstein como “ação fantasmagórica à distância”. Mas o que se acredita é que, no mundo quântico, as partículas podem coordenar suas ações muito mais eficientemente do que no mundo macroscópico, sem realmente estar transmitindo informações entre si.

A propriedade de entrelaçamento é um principio básico da mecânica quântica. Schrödinger a definiu como o fenômeno no qual, após dois sistemas quânticos descritos por suas funções de onda interagem um com o outro, os estados dos dois não podem mais ser descritos como independentes. Ou seja, após a interação, tais estados permanecem “emaranhados”, e qualquer modificação em um implicará na modificação do outro, independentemente das distâncias envolvidas.

Com o exemplo do próprio Einstein, outros cientistas tentaram refutar o principio da não-localidade. Um deles foi John Stewart Bell, que em 1964 deduziu o famoso teorema que leva seu nome. Neste teorema, Bell parte do princípio proposto pelo paradoxo EPR, pelo qual existiria uma teoria de variáveis ocultas por trás da mecânica quântica e pela qual todas as incertezas e estranhezas da mesma poderiam ser justificadas pelo conhecimento incompleto destas variáveis desconhecidas. Com isso, ele formula as desigualdades de Bell, relações matemáticas que provariam a validade de uma teoria de variáveis ocultas locais, ou seja, compatíveis com o principio da localidade clássica.

No entanto, um grande número de experimentos realizados no século passado confirmou a violação das desigualdades de Bell. Por isso, a maioria dos físicos contemporâneos acredita na interpretação de Copenhagen para a mecânica quântica, baseada no colapso de estados sob a condição de observação ou medida, não-localidade e na visão inerentemente probabilística da realidade. Uma teoria de variáveis ocultas locais parece realmente não ser compatível com as observações experimentais.

2) Criptografia atual

Criptografia é o uso de técnicas que permitem codificar uma mensagem de forma que somente o destinatário e o remetente são capazes de decodificá-la. Algumas maneiras são a substituição, a transposição e a permutação. O único algoritmo incondicionalmente seguro encontrado até o momento é o One-time pad, que exige uma chave do tamanho da mensagem. Além disso, persiste o problema de conseguir transmitir a chave de modo seguro. A solução encontrada é criar algoritmos que tenham um custo muito elevado para serem decifrados e que o tempo necessário seja muito maior que a vida útil da informação.

a) Criptografia de chave simétrica

Por este método, tanto o emissor quanto o receptor possuem a mesma chave para codificar e decodificar a mensagem, tornando necessária a existência de um meio seguro de comunicação para a transmissão da chave ou o encontro de ambos, o que é inviável na maioria das situações.

Alguns exemplos de cifras de chaves simétricas são o DES (Data Encryption Standard), o Triple-DES, o ECB (Eletronic Code Book), o CBC (Cipher Block Chaining), o IDEA ( International Data Encryption Algorithm) e o Blowfish.

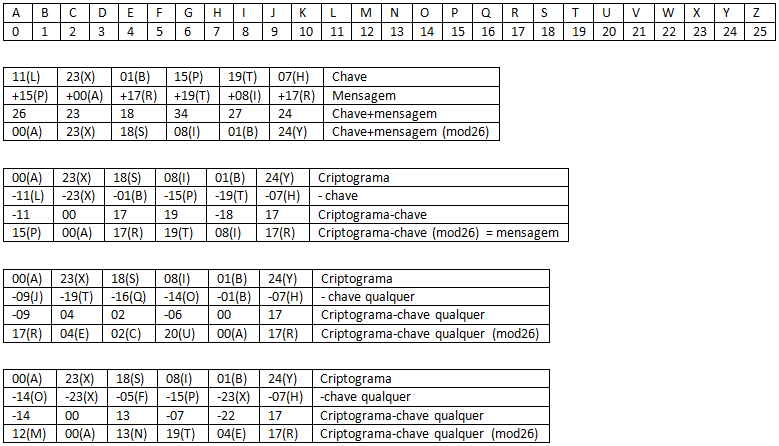

O único algoritmo incondicionalmente seguro encontrado até o momento é o One-Time Pad, que exige uma chave, formada por uma sequência aleatória de caracteres, do tamanho da mensagem. Neste algoritmo, cada letra do alfabeto é associada a um número de 0 a 25 e combina-se o texto com a chave através da soma módulo 26. Para decodificar o criptograma, basta subtrair a chave módulo 26. Sua segurança é garantida, pois mesmo que um espião se utilize de algum algoritmo capaz de encontrar diversas chaves que decodificam o criptograma em mensagens válidas, ele não tem as informações necessárias para saber qual é a mensagem original. O ponto negativo desse algoritmo é a necessidade de encontro físico entre emissor e receptor.

b) Criptografia de chave assimétrica

Neste método existem duas chaves distintas geradas tanto pelo receptor quanto pelo emissor, uma pública e uma privada. O emissor utiliza a chave pública do receptor para codificar a mensagem, e o receptor utiliza sua chave privada para decodificá-la. A chave pública é construída a partir da privada, mas de forma a ser muito difícil inverter o processo (descobrir a chave privada a partir da pública). Neste método, há uma chave para encriptar a mensagem (a pública), e outra para decriptar (a privada). Dessa forma, evita-se a troca de chaves secretas. Esta técnica também apresenta pontos negativos, como a garantia de que a chave pública realmente pertence ao receptor desejado ou a possibilidade de intrusos invadirem o diretório público e falsificarem as chaves.

A técnica mais utilizada e mais bem sucedida até hoje é a RSA (Rivest Shamir-Adleman). A RSA utiliza operações geração de chaves usando multiplicação de grandes números primos e matemática modular. O truque está na facilidade em se gerar a chave através destas técnicas, mas na dificuldade encontrada em se fatorar números grandes em primos para descobrir a chave privada (operação inversa).

Figura 1:Tabela descrevendo o One Time Pad

c) Um pouco sobre computação quântica

A computação quântica se baseia no bit quântico ou qubit, que pode assumir qualquer combinação linear dos valores 0 e 1, ao contrário do bit tradicional, que assume exclusivamente o valor 0 ou 1. Desta forma, os vetores formados pelos qubits são manipulados e torna-se possível o cálculo com estados simultâneos, o que torna o processo muito mais rápido quando comparado à computação tradicional. É como se o computador pudesse testar milhões de combinações de bits ao mesmo tempo, ao invés de testar uma por uma.

A decodificação de sistemas criptográficos necessita de algoritmos que realizem fatoração e determinação de ordem rapidamente. O algoritmo de Shor utiliza a transformada de Fourier quântica, que fatora números grandes em primos em tempo extremamente menor que os algoritmos tradicionais. Este algoritmo é capaz de quebrar o esquema de chave pública RSA por apresentar complexidade polinomial, em contraste com a complexidade exponencial do algoritmo de Shor clássico.

Seguem abaixo os passos necessários para se encontrar os fatores de um número N, múltiplo de dois números primos, pelo algoritmo de Shor (apenas o terceiro passo não pode ser executado por um computador tradicional).

- - Escolhe-se um número A menor que N

- -Calcula-se o maior divisor comum entre A e N. Caso não seja 1, um dos fatores foi obtido.

- - Caso o maior divisor seja 1, calcula-se o período r da função f(x)=(A**x)modN. A computação quântica permite testar vários pares (x,r) simultaneamente, com uma probabilidade maior que ½ de encontrar um par válido.

- - Se r for ímpar ou se A**(r/2)=-1, retorna-se ao primeiro passo.

- - Um dos fatores desejados será o maior divisor comum entre A**(r/2)+- 1 e N.